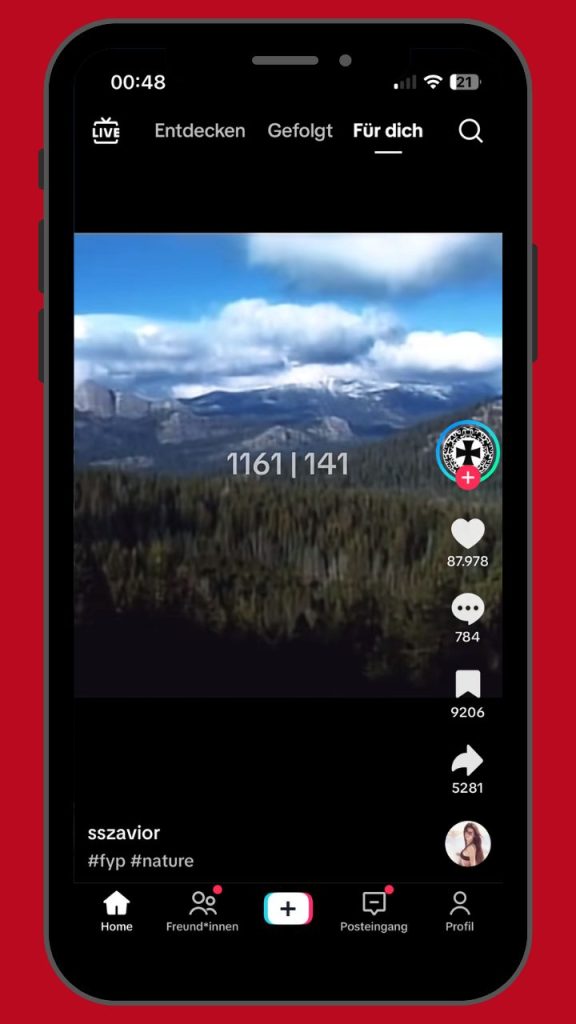

Auf dem Handybildschirm sieht man eine makellose Alpenlandschaft: saftige Wiesen, schneebedeckte Gipfel, die Kamera schwenkt ruhig durch das Bergpanorama. Dazu dröhnt Elektromusik. Der Clip wirkt wie ein „ästhetisches“ Naturvideo, genau die Art Content, der im Feed millionenfach läuft. Wäre da nicht der eingefügte Schriftzug, der mitten im idyllischen Bergblick prangt: ein direktes Zitat von Adolf Hitler. Der Nutzername des Accounts enthält zwei Runen, die sich wie ein „SS“-Kürzel lesen lassen. Das Video hat nach zwei Wochen über 140.000 Aufrufe und mehr als 25.000 Likes gesammelt – der Inhalt ist bis heute online. Öffentlich zugänglich. Auf TikTok. Von Nazis, für Nazis und zukünftige Nazis.

Wie landet man bei solchen Inhalten? In unserem Fall war der Weg erschreckend kurz. Einfach einen neuen TikTok-Account erstellen, nichts kommentieren, nichts liken. Wir haben nur einem einzigen Kanal gefolgt: dem offiziellen TikTok-Account der FPÖ. Wir dachten uns: Wenn jemand sich für Politik – diffus oder klar rechte Politik – interessiert, würde die Person wohl auch dort anfangen. Eine Parlamentspartei scheint ein guter Startpunkt. Danach haben wir einfach nach unten gewischt und geschaut, was passiert – und was uns Tiktok so vorschlägt. Das Ergebnis: Der Algorithmus treibt einen schnell und hürdenlos zu extremistischen und sogar neonazistischen Videos.

TikTok: Der Kanal der Wahl bei jungen Menschen

Aber der Reihe nach: TikTok ist längst keine Nischen-App mehr, sondern eine der wichtigsten Plattformen für politische Inhalte. Auch in Österreich. Laut Angaben des Unternehmens nutzen hierzulande rund 2,5 Millionen Menschen TikTok jedes Monat. Gerade für junge Menschen ist die App besonders prägend: TikTok ist vor allem bei den 11- bis 17-Jährigen extrem beliebt. 64 Prozent dieser Altersgruppe nutzen die Plattform – und davon 8 von 10 sogar täglich. Gleichzeitig gilt TikTok als das am schnellsten wachsende soziale Netzwerk weltweit. Diese Kombination macht die Plattform relevant.

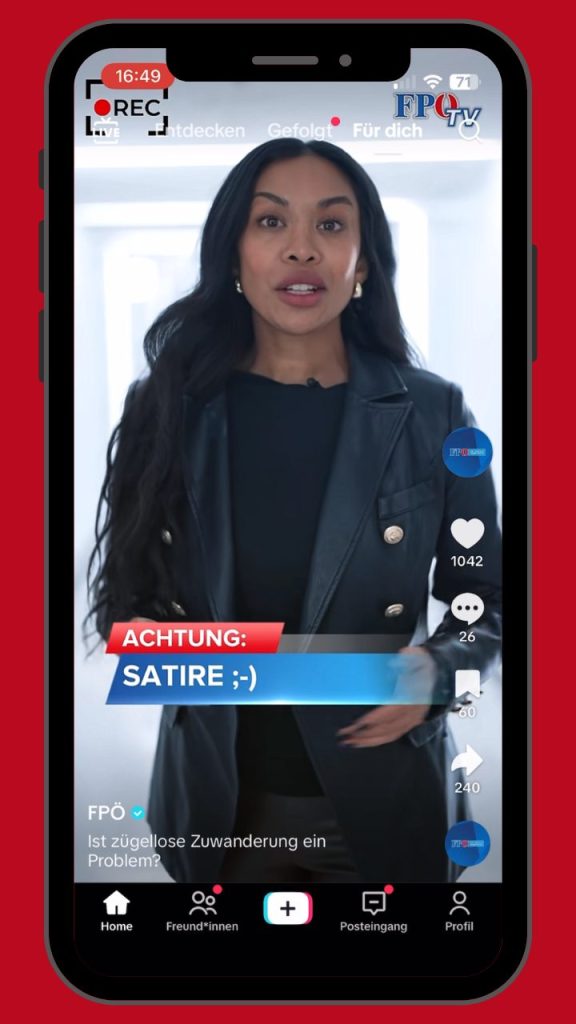

Die FPÖ ist auf TikTok mit großem Abstand die reichweitenstärkste Partei in Österreich. Mit aktuell über 100.000 Follower:innen erreicht sie dort mehr Menschen als alle anderen im Nationalrat vertretenen Parteien zusammen. So hat die FPÖ TikTok als festen Bestandteil ihrer politischen Kommunikation etabliert. Der Kanal wird regelmäßig bespielt, Inhalte sind klar auf Emotionalisierung und Zuspitzung ausgelegt und funktionieren in der Logik der Plattform besonders gut.

Warum TikTok so gefährlich gut funktioniert: der „Für Dich“-Feed

Anders als bei Instagram oder Facebook sehen Nutzer:innen auf TikTok nicht zuerst Inhalte von Freund:innen oder Accounts, denen sie aktiv folgen. Stattdessen dominiert die “Für dich-Seite” (die „for-you“-Page) – ein endloser Feed, der von einem KI-gestützten Empfehlungssystem gesteuert wird und dir ein Kurzvideo nach dem anderen einblendet.

TikTok testet ständig, welche Videos Nutzer am längsten auf der Plattform halten: Was sie länger anschauen, oder mehrmals, was sie kommentieren und „herzen“, merkt sich der Algorithmus. Die Logik: mehr Zeit in der App und mehr Interaktion bedeuten, ich bekomme „more of the same“ angezeigt.

Schon wenige Sekunden Aufmerksamkeit reichen, um in eine bestimmte Richtung weitergeschoben zu werden. Wer einmal bei polarisierenden Inhalten hängenbleibt, bekommt oft noch drastischere Clips nachgeliefert. Wie eine Analyse der Bildungsstätte Anne Frank zeigt, nutzt die extreme Rechte diese Mechanismen gezielt: rechtsextreme Inhalte erscheinen dort häufig nicht als offene Propaganda, sondern getarnt als Meme oder vermeintliche Geschichte-Clips.

Wie schnell das gehen kann, zeigt unser Experiment: Wir haben einen komplett neuen TikTok-Account angelegt und sind nur dem offiziellen FPÖ-Kanal gefolgt. Danach haben wir einfach weitergescrollt, nur im “Für dich“-Feed. Das Ergebnis: Nach kurzer Zeit hat man uns nicht nur FPÖ-nahe Clips vorgeschlagen, sondern auch Inhalte, die den Zweiten Weltkrieg verherrlichen oder mit rechtsextreme Codes arbeiten.

Das Experiment: Nach wenigen Swipes biegt TikTok von FPÖ zur Nostalgie der Nazis ab

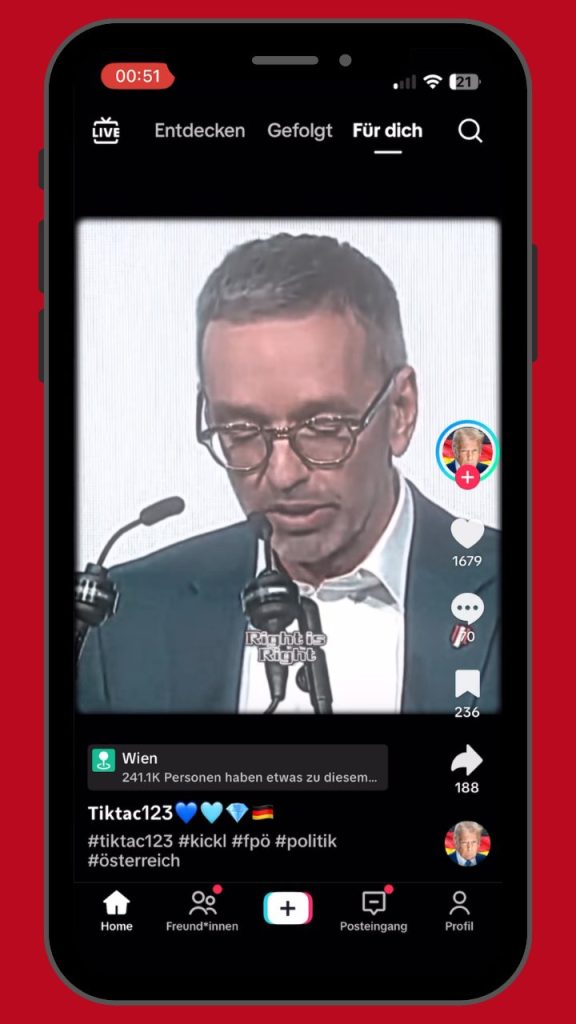

Am Anfang wirkt der Feed harmlos. Zumindest auf den ersten Blick. Nach wenigen Swipes (also: „Wischen“ nach unten) tauchen vor allem Clips auf, die thematisch zur FPÖ passen: kurze Polit-Ausschnitte, Empörungs-Videos, Wut über „die da oben“, Kulturkampf-Schlagworte, Migration als Daueraufreger und auch Content der deutschen AfD. Alles erwartbar.

Doch schon nach wenigen Tagen und einigen Swipes verschiebt sich der Ton. Zwischen patriotischen Symbolvideos und scheinbar „unpolitischen“ Memes erscheinen immer mehr Beiträge, die mit dem Zweiten Weltkrieg spielen: montierte Kriegsaufnahmen, verherrlichende Ästhetik, „History“-Clips mit eindeutiger Schlagseite. An diesem Punkt beginnt TikTok, auch Videos auszuspielen, die mit rechten Codes arbeiten: martialische Musik, Feindbild-Rhetorik, Alltags-Videos mit völkischen Reden untermalt. Content, der so geschnitten ist, dass er nicht wie Propaganda aussieht, sondern wie Unterhaltung.

Wir sehen Memes zu den deutschen Grenzen, Videos als „History-Clips” getarnt, die Deutschland als „Sieger” darstellen und Fotos und Videos aus den Weltkriegen glorifiziert darstellen.

Einige Tage später sind sie plötzlich da: offen rechtsextreme Accounts, die nicht mehr nur andeuten, sondern klar signalisieren, wofür sie stehen – samt Insider-Codes und Verweise auf Nationalsozialismus und die SS.

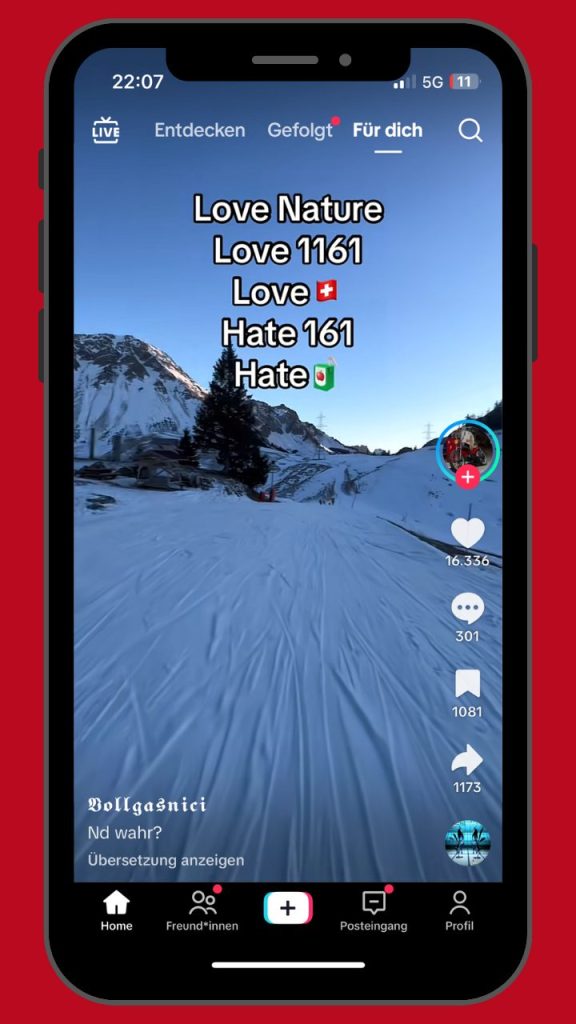

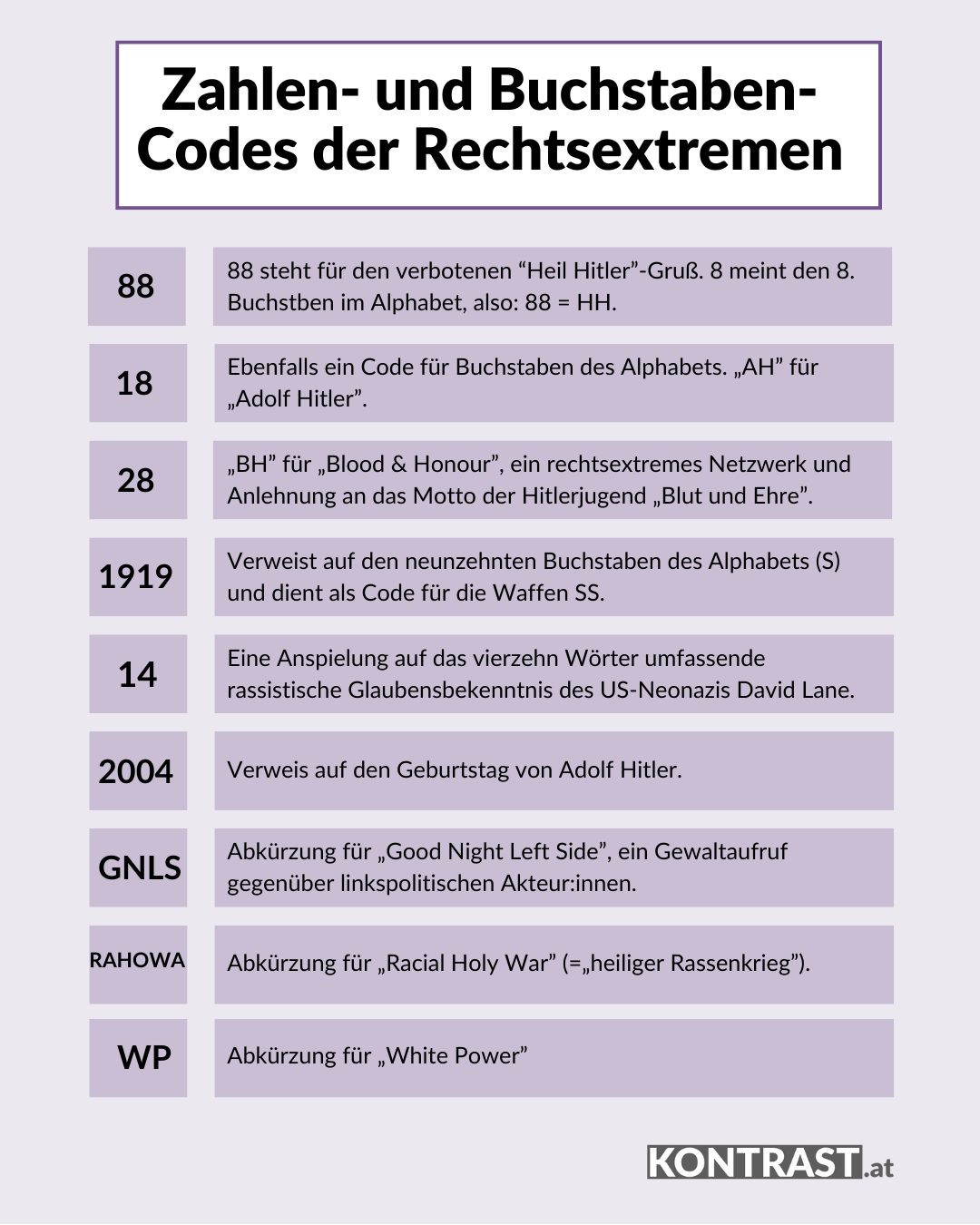

Wir bekommen Kurzvideos in unseren Feed von Accounts mit Namen und Inhalten mit eindeutigem NS-Bezug wie den „SS-Runen” oder rechtsextremen Codes wie die Zahlenfolgen „1161” und „141”. Meist beziehen sich diese Zahlen auf Buchstaben im Alphabet oder konkrete Daten. In unseren Fällen stehen sie für die „Anti-Antifaschistische Aktion“ und den Neonazi-Code.

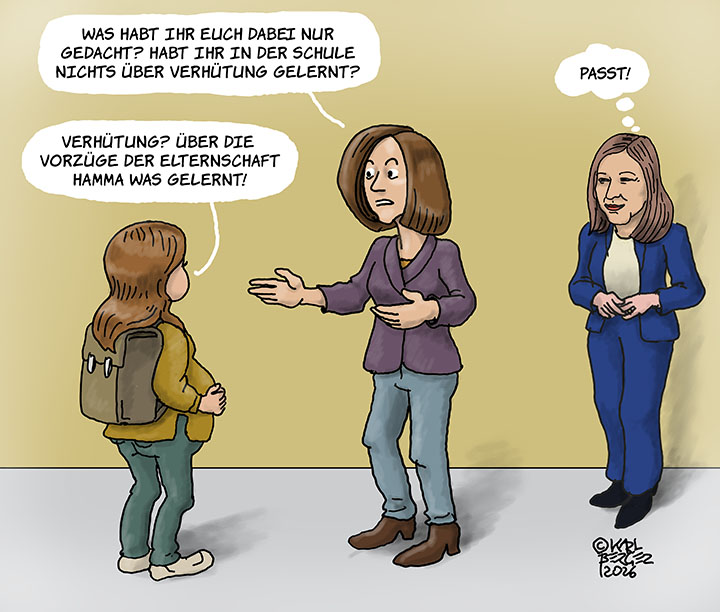

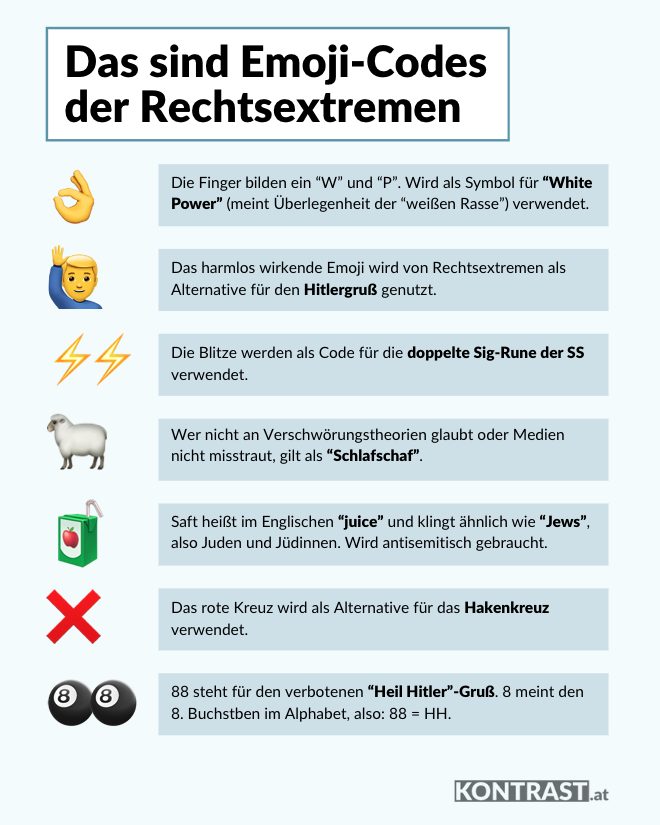

Die gängigsten Codes im Überblick:

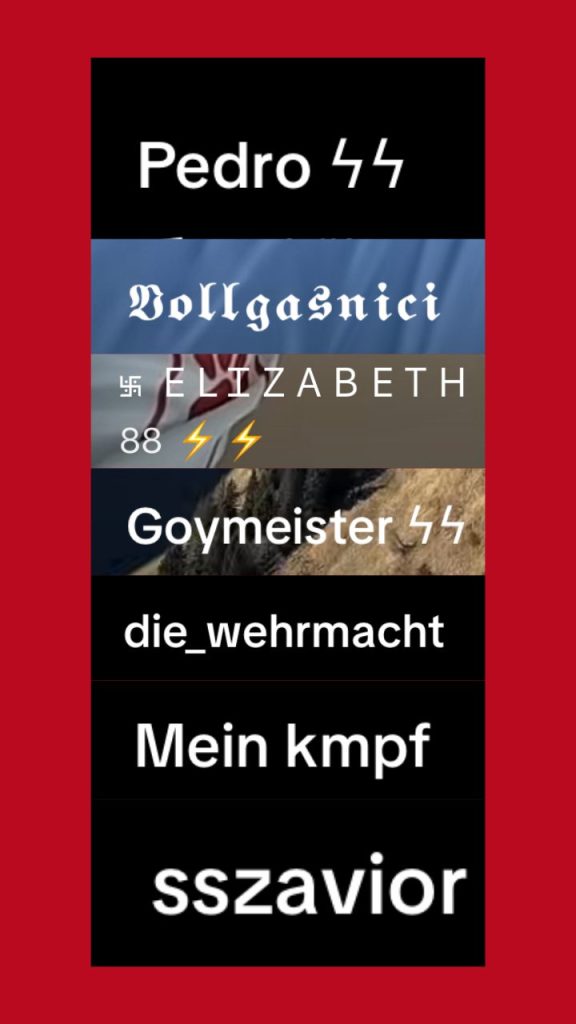

Auch die Namen der Accounts, die diese Videos hochladen, sind verstörend. Wir bekommen Content von Usern in unsere Timeline gespült, die sich „Mein kmpf” oder „die_wehrmacht” nennen oder sogar direkt das Hakenkreuz in ihrem Usernamen als Symbol tragen.

Rechtsextreme Inhalte werden als Trends getarnt

Das Heimtückische an TikTok ist nicht nur, dass extrem rechte Inhalte überhaupt auftauchen, sondern wie sie aussehen. Sie kommen nicht immer als platte Propaganda daher, sondern als scheinbar harmlose Trendvideos: ästhetische Clips, dramatische Musik, „History“-Schnipsel, schnelle Schnittabfolgen.

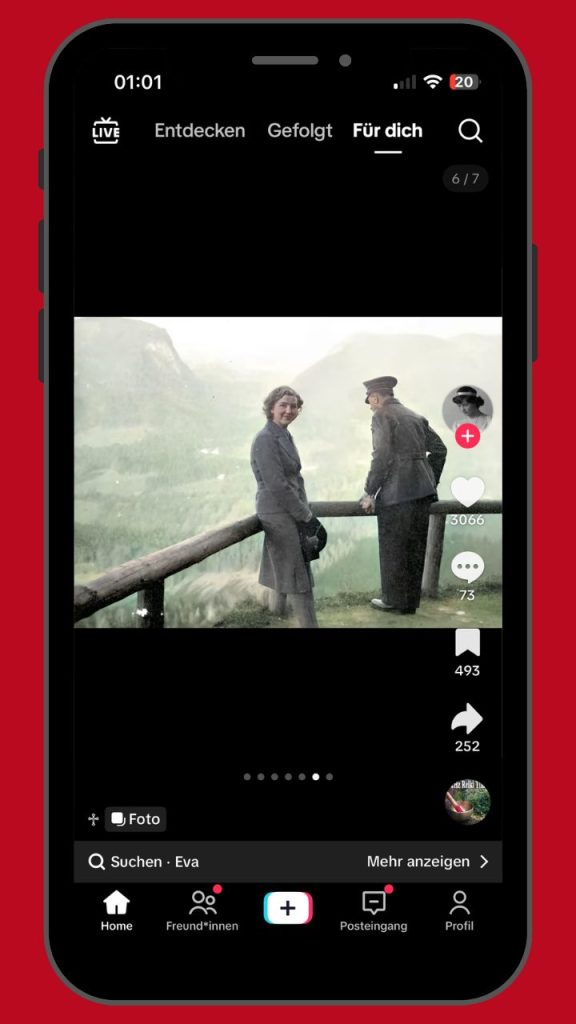

Die Botschaft steckt dabei nicht immer im gesprochenen Text, sondern in Symbolen, Codes und Kommentaren, was sie so schwerer greifbar macht. So gibt es etwa einen aktuellen Trend auf TikTok, bei dem die Beziehung zwischen Eva Braun und Adolf Hitler in hunderten Videos romantisiert und Hitler dabei regelrecht verklärt wird – verpackt als tragische Liebesgeschichte statt als Teil der NS-Massenverbrechen. Auch während unseres Experiments stießen wir auf solche Inhalte.

Andere Codes sind subtiler. So benutzen Rechtsextreme etwa Emojis um ihre Positionen unter Gleichgesinnten auszudrücken. In unserem Experiment stoßen wir auf Textcodes, die als Inhalte über Bilder von harmlosen Skipisten getarnt sind. Als Einstieg schreibt der User „Love Nature”, fügt einige Zahlencodes hinzu und endet sein Meinungsmanifest mit der unscheinbaren Aussage „hate 🧃“. Das Saftpäckchen (engl. “juice”) soll in diesem Zusammenhang für das englische Wort “Jews” (dt. Juden und Jüdinnen) stehen und so Antisemitismus ausdrücken.

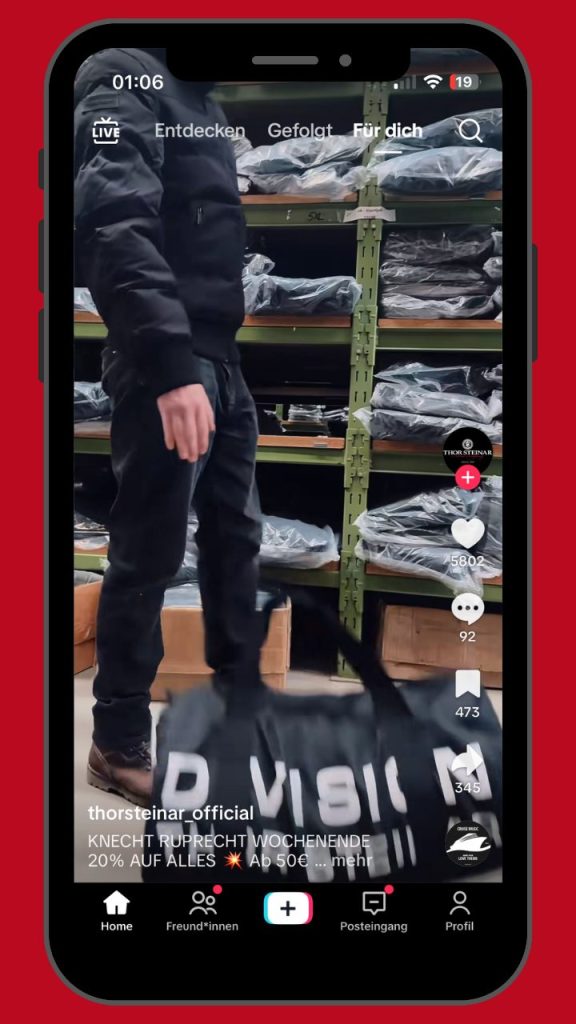

Unser mittlerweile stark rechtsextrem ausgerichteter Algorithmus spült uns nun zunehmend auch Inhalte mit in der rechtsextremen Szene beliebter Kleidung in die Timeline. Wir bekommen Anzeigen für den offiziellen „Thor Steinar” Shop, eine in der Neonaziszene äußerst beliebte Bekleidungsmarke. Auch einzelne Modeartikel mit eindeutiger Gesinnung kommen immer wieder vor.

Transparenzhinweis: Obwohl wir keine Likes oder Kommentare auf rechtsextreme Inhalte abgegeben haben, können wir nicht ausschließen, dass die zu Dokumentationszwecken durchgeführten Screenshots und Bildschirmaufnahmen und das damit einhergehende Verweilen auf den dokumentierten Inhalten den TikTok-Algorithmus beeinflusst haben.

Was tut TikTok gegen diese Inhalte?

Dass diese problematischen Inhalte zu lange online bleiben, kritisiert eine Analyse des Österreichischen Instituts für angewandte Telekommunikation (ÖIAT): Selbst wenn Nutzer:innen extremistische Beiträge melden, passiert laut dem Bericht häufig wenig. Löschungen sind uneinheitlich und für Außenstehende kaum nachvollziehbar.

Dass TikTok das Problem kennt, belegen Fälle aus Österreich. So berichtete Der Standard über eine TikTok-Affäre rund um die FPÖ, bei der die Plattform einen minderjährigen Account innerhalb kurzer Zeit mit rechtsextremen Videos überschwemmt hat – trotz Jugendschutzregeln. TikTok verweist in solchen Fällen auf seine Meldefunktion, über die Nutzer:innen problematische Inhalte anzeigen können.

Zusätzlich blendet die Plattform bei sensiblen Themen wie dem Holocaust inzwischen Informationshinweise ein, die auf historische Fakten und externe Quellen verweisen. Auch bestimmte Schlagworte und Suchbegriffe werden automatisch gefiltert oder blockiert. In der Praxis greifen diese Maßnahmen jedoch zu kurz: Rechtsextreme Inhalte arbeiten gezielt mit Codes, Symbolik und Umschreibungen, um automatische Erkennungssysteme zu umgehen.

Das Ergebnis des Experiments

Nach rund acht Stunden Bildschirmzeit auf TikTok und tausenden Swipes durch die „Für dich“-Seite bleibt vor allem ein Gefühl zurück: Wie schnell sich Inhalte verschieben können, ist erschreckend.

Innerhalb weniger Tage entwickelte sich unser Feed von Parteipolitik über ideologisch aufgeladene Memes bis hin zu klar rechtsextremen Inhalten. Ohne gezielte Suche. Ohne Interaktion. Nur durch Scrollen.

TikTok gibt an, Nutzer:innen ihre Daten transparent zur Verfügung zu stellen. Deshalb haben wir die Daten unseres Test-Accounts angefordert. Nach einigen Tagen des Wartens lieferte die Plattform eine große Menge an Tabellen und Datensätzen. Beim Durchsehen fällt aber schnell auf: Das Meiste davon ist leer. Wie erwartet finden sich keine Suchbegriffe, keine Postings, keine Interaktionen. Doch auch die Informationen auf die wir gehofft hatten – Informationen darüber, welche Interessen oder Präferenzen dem Account zugeordnet wurden – fehlen. Gerade jene Daten, die erklären würden, warum Tiktok bestimmte Inhalte ausgespielt hat, tauchen nicht auf. Welche Informationen der Algorithmus tatsächlich speichert, wie er sie auswertet oder ob der Konzern sie an Dritte weitergibt, bleibt im Verborgenen.

Parallel dazu haben wir während des Experiments vier Accounts mit rechtsextremen Inhalten aktiv gemeldet. Zum Zeitpunkt der Veröffentlichung dieses Artikels sind alle vier Accounts weiterhin online.

Rufe nach Regulierung von Social Media-Plattformen werden lauter

Dass Social Media-Kanäle – bzw. die Konzerne, die sie betreiben – Inhalte ungefiltert zulassen und Algorithmen unseren Blick auf die Welt verzerren, uns radikalisieren, ist für Initiativen und die Politik Anlass, für mehr Sicherheit zu sorgen. Aktuell stehen dabei vor allem Kinder und Jugendliche im Fokus. Die Plattformen setzen sie süchtig machenden Spielen, anonymen Annäherungsversuchen durch Erwachsene, aber eben auch Gewalt-Videos oder rechtsextremen Inhalten aus.

„Tech-Konzerne haben in der Regulierung ihrer Inhalte versagt. Wenn man User:innen schon nach wenigen Klicks Gewalt oder extremistische Inhalte angezeigt, müssen wir handeln. Wir dürfen nicht vergessen, dass schon Kindern derartige Inhalte ausgespielt werden“, erklärt Paul Stich, Jugendsprecher der SPÖ, warum seine Partei ein Social Media-Verbot für Kinder forciert.